导读同时定位和映射(SLAM)是同时估计传感器姿态以及周围场景几何的任务。然而,现有的大多数SLAM系统都是为静态世界设计的,这是不现实的。arXi...

同时定位和映射(SLAM)是同时估计传感器姿态以及周围场景几何的任务。然而,现有的大多数SLAM系统都是为静态世界设计的,这是不现实的。

arXiv.org最近的一篇论文提出了一个强大的对象级动态SLAM系统。

为了在高度动态的环境中估计相机位姿,研究人员通过联合估计相机位姿、速度和IMU偏差,以紧密耦合的方式整合来自惯性测量单元(IMU)和RGB-D传感器的读数。该方法即使在高度动态的情况下也能实现可靠的相机姿态估计,同时保持重力方向可观察。

此外,通过使用基于关键帧的特征匹配恢复先前重建的模型,引入了对象重新定位步骤。当机器人探索更大规模的环境时,它减少了对象映射复制。

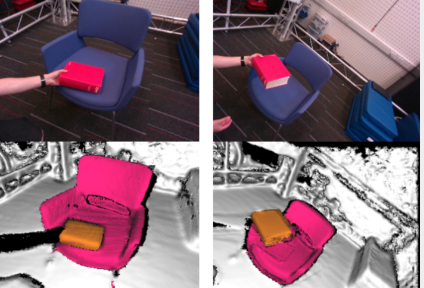

在本文中,我们提出了一种紧耦合的视觉惯性对象级多实例动态SLAM系统。即使在极度动态的场景中,它也可以针对相机位姿、速度、IMU偏差进行稳健优化,并构建环境的密集3D重建对象级地图。由于其强大的传感器和对象跟踪功能,我们的系统可以通过将相关的颜色、深度、语义和前景对象概率逐步融合到每个对象模型中来稳健地跟踪和重建任意对象的几何形状、它们的语义和运动。此外,当物体丢失或移动到相机视野之外时,我们的系统可以在重新观察时可靠地恢复其姿势。我们通过在现实世界的数据序列中进行定量和定性测试来证明我们方法的稳健性和准确性。