导读最近,在文本到视频的检索领域取得了显着进展。然而,当前的系统主要是为非常短的视频设计的,而大多数真实世界的视频通常会捕捉复杂的人类

最近,在文本到视频的检索领域取得了显着进展。然而,当前的系统主要是为非常短的视频设计的,而大多数真实世界的视频通常会捕捉复杂的人类动作,这些动作可能会持续几分钟甚至几小时。

arXiv.org上发表的一篇科学论文提出了一种专注于远程视频的高效视听文本到视频检索系统,从而解决了这一限制。

研究人员注意到,大多数相关的视觉信息可以在几个视频帧中捕获,而时间动态可以在音频流中简洁地编码。因此,所提出的框架不是从长视频中处理许多密集提取的帧,而是对伴随密集音频的稀疏采样视频帧进行操作。

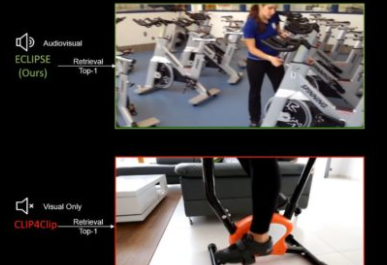

结果表明,与仅远程视频的方法相比,新框架以降低的计算成本导致更好的视频检索结果。

我们介绍了一种用于远程文本到视频检索的视听方法。与以前为短视频检索设计的方法(例如,持续时间5-15秒)不同,我们的方法旨在检索捕获复杂人类动作的一分钟长的视频。标准纯视频方法的一个挑战是与处理从如此长的视频中密集提取的数百个帧相关的大量计算成本。为了解决这个问题,我们建议用紧凑的音频提示替换部分视频,这些提示可以简洁地总结动态音频事件并且处理成本低。我们的方法名为ECLIPSE(带声音编码的高效剪辑),通过添加一个统一的视听转换器块,从视频和音频流中捕获互补线索,使流行的CLIP模型适应视听视频设置。除了是2。