语音和语言识别技术是一个快速发展的领域,这导致了新的语音对话系统的出现,例如AmazonAlexa和Siri。对话人工智能(AI)系统发展的一个重要里程碑是增加了情商。一个能够识别用户情绪状态的系统,除了能够理解语言之外,还会产生更感同身受的反应,从而为用户带来更身临其境的体验。

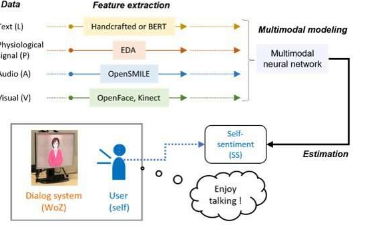

“多模态情感分析”是一组方法,它们构成了带有情感检测的AI对话系统的黄金标准。这些方法可以从一个人的语音、声音颜色、面部表情和姿势自动分析一个人的心理状态,对于以人为中心的人工智能系统至关重要。该技术可能会实现一种具有超越人类能力的情商人工智能,它可以理解用户的情绪并相应地产生响应。

然而,目前的情绪估计方法只关注可观察到的信息,并没有考虑到生理信号等不可观察信号中包含的信息。这些信号是一个潜在的情绪金矿,可以极大地提高情绪估计性能。

在IEEETransactionsonAffectiveComputing杂志上发表的一项新研究中,生理信号首次被日本研究人员添加到多模态情感分析中,这是一个由日本科学技术研究所(JAIST)副教授ShogoOkada和科学与工业研究所的KazunoriKomatani教授组成的合作团队在大阪大学。“人类非常善于隐藏自己的感受。用户的内心情绪状态并不总是能准确地反映在对话内容中,但由于人很难有意识地控制自己的生物信号,例如心率,因此使用这些来估计他们的情绪状态可能很有用。这可以使人工智能具有超越人类的情绪估计能力,”冈田博士解释说。

该团队使用从26名参与者获得的对话AI分析了2,468次交流,以估计用户在对话期间体验到的愉悦程度。然后要求用户评估他们发现对话的愉快或无聊程度。该团队使用了名为“Hazumi1911”的多模态对话数据集,该数据集独特地将语音识别、语音颜色传感器、面部表情和姿势检测与皮肤电位(一种生理反应传感形式)结合在一起。

“在比较所有不同的信息源时,生物信号信息被证明比声音和面部表情更有效。当我们将语言信息与生物信号信息相结合,在与系统交谈时估计自我评估的内部状态时,人工智能的性能变得可以与人类媲美,”冈田博士兴奋地评论道。

这些发现表明,人类生理信号的检测,通常在我们的视野中是隐藏的,可以为高度情感智能的基于人工智能的对话系统铺平道路,从而实现更自然和令人满意的人机交互。此外,情绪智能的人工智能系统可以通过感知日常情绪状态的变化来帮助识别和监测精神疾病。它们还可以在教育中派上用场,人工智能可以判断学习者是否对讨论的话题感兴趣和兴奋,或者感到无聊,从而改变教学策略和更有效的教育服务。