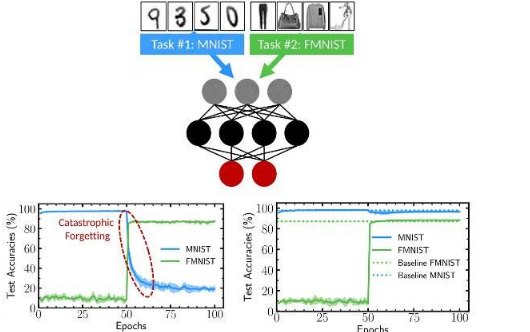

深度神经网络在包括图像和文本分类在内的多项任务上取得了非常有希望的结果。尽管如此,许多这些计算方法都容易出现所谓的灾难性遗忘,这实质上意味着当他们接受新任务训练时,他们往往会很快忘记如何完成他们过去训练完成的任务。

Université Paris-Saclay-CNRS 的研究人员最近引入了一种新技术来减轻二值化神经网络中的遗忘。这项技术发表在Nature Communications 上的一篇论文中,其灵感来自突触化生性的概念,突触(两个神经细胞之间的连接点)通过该过程适应并随着时间变化以响应经验。

“我的团队多年来一直在研究二值化神经网络,”进行这项研究的研究人员之一达米安·奎利奥兹 (Damien Querlioz) 告诉 TechXplore。“这些是深度神经网络的高度简化形式,是现代人工智能的旗舰方法,可以执行复杂的任务,同时减少内存需求和能源消耗。与此同时,我们的一年级博士生 Axel小组,开始研究由 Stefano Fusi 于 2005 年引入的突触可塑性模型。”

神经科学研究表明,神经细胞适应经验的能力最终使人脑能够避免“灾难性遗忘”,并记住即使在处理新任务后如何完成给定任务。然而,大多数人工智能 (AI) 代理在学习新任务后会很快忘记之前学习的任务。

“几乎是偶然地,我们意识到二值化神经网络和突触可塑性这两个以截然不同的动机进行研究的主题实际上是相互关的,”Querlioz 说。“在二值化神经网络和化生的 Fusi 模型中,突触的强度只能取两个值,但训练过程涉及一个‘隐藏’参数。这就是我们如何得到二值化神经网络可以提供一种方法的想法缓解人工智能中灾难性遗忘的问题。”

为了在二值化神经网络中复制突触可塑性的过程,Querlioz 和他的同事们引入了一种“巩固机制”,其中一个突触在同一方向上更新得越多(即,其隐藏状态值上升或下降),它应该更难向相反的方向切换回来。这种机制受复可塑性 Fusi 模型的启发,与通常训练二值化神经网络的方式略有不同,但它对网络的灾难性遗忘有显着影响。

“我们研究中最显着的发现是,首先,我们引入的新整合机制有效地减少了遗忘,并且它仅基于突触的局部内部状态而这样做,而无需更改任务之间网络优化的指标,与其他文献方法相反,”Axel Laborieux,博士一年级。进行这项研究的学生告诉 TechXplore。“这一特性对低功耗硬件的设计特别有吸引力,因为人们必须避免数据移动和计算的开销。”

这组研究人员收集的研究结果可能对人工智能代理和深度神经网络的发展具有重要意义。最近论文中引入的整合机制可以帮助减轻二值化神经网络中的灾难性遗忘,从而开发能够在各种任务上表现良好的 AI 代理。总体而言,Querlioz、Laborieux 及其同事 Maxence Ernoult 和 Tifenn Hirtzlin 的研究也强调了在尝试开发性能更好的 AI 代理时从神经科学理论中汲取灵感的价值。

“我们的团队专注于使用纳米技术开发低功耗 AI 硬件,”Querlioz 说。“我们相信我们在这项工作中提出的化生二值化突触非常适合基于纳米技术的实现,我们已经开始基于这个想法设计和制造新设备。”